Wyszukaj w wideo

AI w medycynie – realna pomoc czy zagrożenie

Konferencja "Specjalista w praktyce: Pediatria 2025" (jesień 2025)

Najmłodsi pacjenci potrafią zaskakiwać – skąpymi objawami, szybkim pogorszeniem stanu i obrazami klinicznymi, które nie mieszczą się w schematach znanych z medycyny dorosłych. Codzienna praktyka pediatryczna wymaga czujności, trafnej interpretacji sygnałów alarmowych oraz umiejętnej komunikacji z opiekunami, którzy często potrzebują równie dużego wsparcia jak dziecko. Materiały z konferencji online „Specjalista w praktyce: Pediatria”, która odbyła się 15 grudnia 2025 r., to zapis wykładów i paneli dyskusyjnych przygotowanych z myślą o rezydentkach i rezydentach pediatrii oraz lekarzach rozpoczynających pracę w tej dziedzinie.

Odcinek 2

Podczas swojego wykładu prof. dr hab. n. med. Hanna Szajewska przedstawiła podstawowe pojęcia związane ze sztuczną inteligencją oraz aktualne przykłady jej zastosowania w medycynie. Omówiła potencjalne korzyści i ograniczenia wykorzystania AI w praktyce klinicznej. Wykład koncentrował się na kluczowym pytaniu, czy i w jakim stopniu AI może realnie poprawiać wyniki leczenia pacjentów.

Dzień dobry państwu.Witam państwa bardzo serdecznie.AI w medycynie realna pomocczy zagrożenie?Ja się nazywam Hanna Szajewska,jestem kierownikiem Kliniki Pediatrii Warszawskiego UniwersytetuMedycznego.

Proszę Państwa, AI już tujest i tu zostanie.Profesor Andrzej Dragan, znany polskifizyk dopiero co powiedział: Zdumiewa mnie,że są jeszcze ludzie, którychto nie rusza, że nie sązaskoczeni tym, co się dzieje.A czasopismo Time parę dnitemu ogłosiło AI jako swojego rodzajuczłowieka, Człowieka Roku.

Ale wróćmy do nas.Wyobraźmy sobie sytuację znacznie bardziejbanalną.Jutro w przychodni, jutro wpaństwa szpitalu szef, kolega, przedstawiciel firmyprzychodzi do państwa z nowymurządzeniem AI.I każdy z nas zadajesobie to pytanie stosować czy niestosować?Realna pomoc czy zagrożenie?

I to jest dokładnie pytanie,które zadali mi organizatorzy tego dzisiejszegospotkania.Za zaproszenie bardzo dziękuję ispróbuję na to pytanie Państwu odpowiedzieć.A będę się w dużejmierze posiłkowała raportem, który ukazał sięw jednym z wiodących czasopismmedycznych Jama.Raport, który dotyczył dokładnie właśnietego, o czym mówimy, czyli AIw medycynie.

I proszę zobaczyć, AI zmieniaochronę zdrowia na bezprecedensową skalę.Potencjalne korzyści są ogromne, aleryzyka równie duże.

To, co będę chciała dzisiajz Państwem zrobić, to będę chciałaPaństwu króciutko powiedzieć kilka podstawowychterminów związanych z AI, ze sztucznąinteligencją.Trochę skupię się na uczeniumaszynowym i powiem Państwu za chwilędlaczego.Pokażę państwu kilka przykładów zastosowaniaAI w medycynie, głównie oczywiście wpediatrii.Powiem na temat wyzwań wzastosowaniu AI.I wreszcie na koniec znowuposiłkując się raportem z czasopisma JAMA,spróbuję odpowiedzieć na kluczowe pytanie,czy AI w chwili obecnej poprawiawyniki kliniczne?Zacznijmy w związku z tym

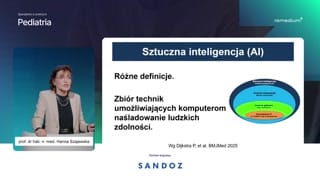

od tego pierwszego, czyli podstawowych terminów.Sztuczna inteligencja to jest, proszępaństwa, znacznie więcej niż czat GPT,mimo że dla bardzo wieluosób spośród nas, włączając w torównież ten flirt, swojego rodzajuflirt ze sztuczną inteligencją zaczął sięod czata GPT.Ale to jest znacznie więcej.

Są takie terminy jak sztucznainteligencja, uczenie maszynowe, uczenie głębokie czygeneratywna AI.I spróbujmy się przynajmniej natych terminach skupić, zaczynając od pierwszego,czyli sztuczna inteligencja.Jak ją zdefiniować?No bardzo dobre i bardzotrudne pytanie.Są różne definicje i taknaprawdę odpowiedź zależy od tego, kogozapytamy.Ale powiedzmy, że to sątakie techniki, które umożliwiają komputerom naśladowanieludzkich zdolności.

Częścią AI, proszę zobaczyć, tylkoczęścią AI jest uczenie maszynowe.Machine learning to jest takaczęść sztucznej inteligencji, która pozwala algorytmomuczyć się z danych, niezwykleważne i przewidywać wyniki bez ręcznegoprogramowania każdego kroku.

Ja trochę się zatrzymam natym uczeniu maszynowym, a to dlatego,że w medycynie z uczeniemmaszynowym mamy bardzo dużo do czynienia.I pytanie jest, jak ucząsię maszyny?No uczą się tak, jaki my.Podobnie jak my, metodą próbi błędów.I teraz, w takim dużymuproszczeniu spróbuję Państwu pokazać kilka procesów,kilka kroków, które towarzyszą temuuczeniu maszynowemu.W dużym uproszczeniu, ale myślę,że ważne, żebyśmy wszyscy wiedzieli, jakto wygląda.

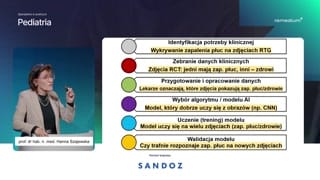

Oczywiście wszystko zaczyna się odtego.Zastosowanie AI zaczyna się odtego, że identyfikujemy jakąś potrzebę kliniczną.Zbieramy dane kliniczne, przygotowujemy je,opracowujemy te dane, wybieramy algorytm, wybieramymodel AI.I tu państwu pokazałam kilkatych algorytmów uczenia maszynowego, w tymsieci neuronowe.Kolejny etap, niezwykle ważny.To na tych danych modelsię uczy, algorytm się uczy, znajdujejakieś trendy, znajduje jakieś, jakieśwzorce, potem walidujemy ten model, sprawdzamyjak on działa na danych,których do tej pory nie widział.To jest tak ogólnie.A teraz spróbujmy przyjrzeć się

bardzo konkretnej sytuacji.Wyobraźmy sobie, że chcemy miećmodel.Chcemy mieć algorytm, który pozwalanam rozpoznawać zapalenia płuc na zdjęciachradiologicznych.Nie mamy radiologa i chcemymieć takie urządzenie.W związku z tym identyfikujemytą naszą potrzebę kliniczną.To jest właśnie wykrywanie zapaleniapłuc na zdjęciach radiologicznych.

Zbieramy dane kliniczne.Co to znaczy?Zbieramy tysiące, dziesiątki tysięcy, setkitysięcy.Im więcej, tym lepiej zdjęćradiologicznych.Przy czym ważne jest, żebyto były zdjęcia nie tylko prawidłowyobraz, ale żeby było bardzodużo zdjęć, w których będą nieprawidłoweobraz, czyli że będzie tozapalenie płuc.

Przygotowujemy i opracowujemy te dane.Co to znaczy?Lekarze oznaczają, na których zdjęciachjest zapalenie płuc po to, żebypotem narzędzie algorytm mógł sięnauczyć rozpoznawać według własnego, nie zaprogramowanego,tylko według własnego klucza.

Następny etap to jest wybóralgorytmu i modelu AI, który będzienam służył do tego rozpoznawania,do tego uczenia się. Kolejny niezwykle ważnyetap, tak jak powiedziałam, tojest uczenie.To jest trening modelu.Model uczy się na bardzowielu zdjęciach, znajduje jakiś wzorzec.My mu nie mówimy, jakrozpoznawać, że to jest zapalenie płuc,a to nie.Myśmy mu tylko oznaczyli tezdjęcia i powiedzieli: Tu jest zapaleniepłuc, a tu nie ma.Ale wzorzec musi się nauczyćsam.Kolejny etap to jest walidacja,czyli sprawdzamy, czy trafnie rozpoznaje zapaleniepłuc.Pokazujemy mu zdjęcie, którego dotej pory nie widział i sprawdzamy:dobrze rozpoznaje czy nie.

Czyli to jest uczenie maszynowe.A taką częścią uszenia-- uczeniamaszynowego, też niezwykle ważne, jeżeli chodzio medycynę, to jest uczeniegłębokie, które właśnie wykorzystuje sieci neuronowe.Te, które są takie algorytmydo rozwiązywania bardzo skomplikowanych, bardzo trudnychzadań.

Generatywna sztuczna inteligencja, taka jakna przykład ChatGPT, to jest znowukolejna podgrupa sztucznej inteligencji.I to jest taka sztucznainteligencja, która tworzy nowe treści, takiejak teksty, obrazy czy dźwięki.Coś, z czym my, takjak powiedziałam na początku, dla bardzowielu z nas ten flirtz-ze sztuczną inteligencją od tego sięzaczął.

Dlaczego teraz?No dlatego teraz, że mamyod parunastu lat olbrzymie ilości danych.

Kolosalne.I to się zwiększa ibędzie się zwiększało.Mamy komputery z coraz większąmocą obliczeniową i to też siębędzie zmieniało.No chociażby pomyślmy o komputerachkwantowych.No i wreszcie mamy nowealgorytmy.To taki, za który GeoffreyHinton między innymi dostał Nagrodę Nobla.Sieci, sieci neuronowe, czyli paręrzeczy, które sprawia, że w tejchwili o tej sztucznej inteligencjimówimy tak dużo, jak teraz.

Sztuczna inteligencja już tu jest,ale pytanie gdzie?Gdzie ona jest, jeżeli chodzio medycynę?Nie ma żadnych wątpliwości, żetakim obszarem najlepiej udokumentowanym, jeżeli chodzio zastosowanie AI, to jestobrazowanie, wszelkiego rodzaju obrazowanie.Algorytm widzi, model widzi, aleproszę pamiętać, nie rozumie pacjenta, nierozumie kontekstu.W związku z tym możeuzupełnić lekarza, ale nie będzie gozastępował, bo jak na razienikt z nas nie chciałby, żebyjakakolwiek choroba, na przykład nowotwór,był rozpoznawany na podstawie tylko iwyłącznie z obrazu, który zostałzinterpretowany przez model AI.

Tu kolejny przykład: model opartyna AI do wykrywania chorób napodstawie obrazów siatkówki oka.Bardzo duże badanie, ponad milionsześćset zdjęć, przy czym bardzo dużozdjęć, bo to nie tylkoliczba się liczy, ale też takie,które miały pewne choroby.To pozwala na rozpoznanie choróbokulistycznych, to jest oczywiste, ale równieżchorób neurologicznych, chorób sercowo-naczyniowych.Uzupełnienie, ale na pewno niejako jedyny model do rozpoznawania chorób.

Narzędzia kliniczne w pediatrii bardzowiele, ja tylko kilka z nichtutaj wypisałam.One głównie służnie-- służą główniedo predykcji, do screeningu.No i spróbuję Państwu pokazać.Sporo modeli do predykcji ryzykasepsy u dzieci starszych, ale równieżu noworodków.Tutaj akurat zebrane takie dotyczącepredykcji ryzyka sepsu i martwiczego zapaleniau noworodków.Nie jako jedyne do rozpoznawania,jako uzupełnienie tego, co robią lekarze.

Wczesna identyfikacja ryzyka zaburzeń zespektrum autyzmu to jest takie narzędzie,które notabene uzyskało pozytywną opinięFDA.Niewiele uzyskało tak naprawdę, aleto akurat ma.Wczesna identyfikacja, ważne, nie zastąpilekarza, ale na pewno pomoże zidentyfikowaćdzieci, które będą wymagały dalszejkonsultacji.

Ostre zapalenie ucha środkowego.Wiemy o tym, że choćchodzi o poprawne rozpoznawanie, nie jesteśmyjeszcze idealni, koło siedemdziesięciu procent,a to jest publikacja w JAMAPediatrics, która pokazuje trafność diagnostycznąna poziomie dziewięćdziesięciu czterech procent.Wspiera, nie zastępuje całkowicie.

Mówiłam o obrazach siatkówki udorosłych, ale również u wcześniaków.AI w screeningu retinopatii uwcześniaków.Uzupełnia, nie zastąpi jak narazie całkowicie lekarzy.

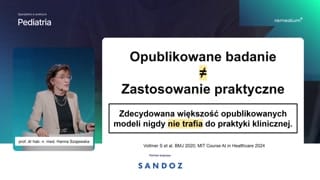

I mogłabym jeszcze o takichbadaniach i takich narzędziach powiedzieć Państwubardzo dużo, ale proszę pamiętać,że opublikowane badanie nie oznacza zastosowaniapraktycznego.Zdecydowana większość opublikowanych modeli nigdynie trafia do praktyki klinicznej.To, że jakaś publikacja dotyczącaAI, a ich się ukazuje bardzodużo, uczenia maszynowego, głębokiego uczeniasię ukazuje, nie oznacza jeszcze, żeto jest-- będzie stosowane wpraktyce klinicznej.A część trafia, ale pytanieniezwykle istotne jest, czy przekłada sięto na korzyść dla pacjenta,wymierną korzyść dla pacjenta.

To są nie tylko narzędzia,które stosują lekarze.Proszę też zobaczyć narzędzia dlapacjentów, w których AI jest częstowbudowane w oprogramowanie.To są różnego rodzaju aplikacjezdrowotne, to są słynne chatboty, naprzykład do wsparcia psychicznego.To jest analiza danych zurządzeń noszonych na zegarki, opaski.Tutaj stworzony obrazek, który zostałstworzony przez sztuczną inteligencję.

Jak to wygląda w przypadkudziecka?Z raportów JAMIE, o którympaństwu-- na który państwu na początkuopowiedziałam, oszacowane jest, że naświecie jest ponad trzysta pięćdziesiąt tysięcyaplikacji zdrowotnych, z których takjak powiedziałam, bardzo wiele ma-- jestpodłączonych do programowania do AI.Rynek aplikacji zdrowotnych szacuje się,że to jest siedemdziesiąt miliardów dolarówamerykańskich.Porównałam z budżetem polskim, mniejwięcej ChatGPT twierdzi, że to jestdwieście dziesięć miliardów dolarów.Czyli aplikacje zdrowotne to jestmniej więcej jedna trzecia budżetu Polski.

I pewien paradoks.Ogromny rynek-Minimalna ocena i minimalny,żeby nie powiedzieć nadzór regulacyjny.Z ponad trzysta pięćdziesiąt tysięcyaplikacji każdy z nas będzie sięz tym spotyka i będziesię z tym spotykał.

AI organizacyjnie coś, co możekażdego z nas zainteresować.Z czym to się wiążew przychodni, w szpitalu?To niewątpliwie szansa na usprawnienieorganizacji pracy, na automatyczną-- na automatyzacjędokumentacji medycznej, na wsparcie, niezastąpienie, ale wsparcie decyzji klinicznych, napoprawienie ciągłości opieki i monitorowanie,na zapewnienie szybkiego dostępu do aktualnejwiedzy.

Bardzo dużo mówi się otak zwanych AI scribe, czyli narzędziachAI wspierających tworzenie dokumentacji medycznej.Teoretycznie nas zastąpi, w praktycepewno też nas zastąpi, ale napewno mniej biurokracji, potencjalnie więcejczasu.Ale to jest publikacja, któraukazała się kilka dni temu wNew England Journal of MedicineAI.Notabene czasopismo, które gorąco polecamkażdemu, kto się zajmuje, kto jestzainteresowany AI.Czy to zwiększa naszą produktywność,naszą wydolność?No jak państwo widzą, jeszczenie.Na razie jest dyskusyjne.Dodatkowo i na to zwracająautorzy tego edytorialu, może wiązać sięz presją na przyjęcie większejliczby pacjentów.Bo skoro lekarze mają więcejczasu, bo mają, bo się oszczędzaczas, to mogą przyjąć wtym czasie znacznie więcej pacjentów.

No i oczywiście jeszcze jednarzecz, z której pewno bardzo wieleosób spośród nas korzysta, aleteż pacjenci korzystają jako źródło wiedzymedycznej.Duże modele językowe, znowu ChatGPTjako przykład, ale Copilot, Gemini iwiele innych.Tak, ale proszę pamiętać, żepomimo że kolejne wersje są corazlepsze, mamy brak gwarancji poprawności.Halucynacje dalej są istotnym problemem.Błędne syntezy dalej są problemem.Brak przejrzystości źródeł i aktualnościdanych.Ryzyko nadmiernego zaufania i todotyczy zarówno lekarzy, jak również pacjentów,którzy ślepo mogą wierzyć wto, co ChatGPT im powiedział ibrak jakiegokolwiek nadzoru nad AIjako źródłem wiedzy.

Jeżeli miałabym dać jakąś praktycznąwskazówkę, z czego warto korzystać, jeżelikorzystamy z dużych modeli językowychjako źródła wiedzy medycznej, to napewno z Open Evidence.Dlaczego?Dlatego, że jest trenowany namedycznych danych.Tylko i wyłącznie na medycznychdanych.Pamiętacie Państwo, jak pokazywałam Państwute kroki poszczególne w uczeniu maszynowymi mówiłam, jak ważny jestten trening.Dane, na których się uczymy.Jeżeli się uczymy z marnychksiążek, to ten produkt końcowy teżbędzie marny.Jeżeli tu jest tak, żetrenowanie jest na medycznych danych, tojest szansa na to, żete informacje będą, to są wiarygodnei są sprawdzone.Czyli cytuję tylko i wyłącznieprawdziwe źródła, aczkolwiek jest bardzo zorientowanyna rynek amerykański.Nie liczcie Państwo na to,że będą tam cytowania z polskich,z polskich publikacji, chyba żesą polscy autorzy, którzy publikują wrenomowanych czasopismach.Open Evidence, bardzo polecany przezczasopisma typu New England Journal ofMedicine, JAMA czy, czy Lancet.

A to redaktor naczelny NewEngland Journal of Medicine AI, którypowiedział i to taka zachęta,żeby korzystać z tych dużych modeli.Ciągle korzystam z dużych modelijęzykowych, aby uzyskać drugą opinię, przyczym mówi, że korzysta zreguły z kilku modeli, a nigdyz jednego, ponieważ za każdymrazem, w zależności od tego, jaksformułujemy ten prompt, to możemydostać trochę inną opinię.

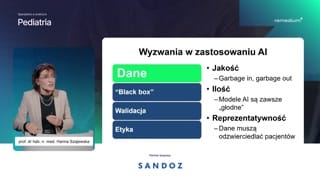

Proszę Państwa, opowiedziałam Wam-Państwu trochęo tym, co jest, co jestmożliwe, ale też są licznewyzwania, jeżeli chodzi o AI ija chcę skomentować tylko kilkaz nich.

Po pierwsze dane.No, są takie powiedzenie jesttakie angielskie: garbage in, garbage out.Śmiecie wrzucamy, śmiecie wyrzucamy.Jakość danych, ilość danych ireprezentatywność mają kolosalne znaczenie.I jakość.Jak się uczymy z marnegopodręcznika, to nasza wiedza jest marna.Jeżeli ten model uczy sięna marnych danych, na danych marnejjakości, to naprawdę nie masię spodziewać, że będzie potem, żebędziemy mieć algorytm, który rozwiąże,czy będzie rzeczywiście pomagał rozwiązać naszeproblemy.

Ilość.Modele AI są zawsze głodne,przy czym chodzi nie tylko ogólnąpulę danych, ale też danych,które mamy ten nasz punkt końcowy,który nas interesuje.Wracając do tych zdjęć radiologicznych.Nie tylko, żeby ta pulazdjęć radiologicznych była bardzo duża, ależeby w tej puli byłydobrze opisane, prawidłowo opisane, duża liczbazdjęć z zapaleniem płuc.

I reprezentatywność — dane musząodzwierciedlać pacjentów.Jeżeli mamy model, który urządzenie,które ma, służy nam do rozpoznawaniachorób skóry i on byłtrenowany tylko i wyłącznie na osobachz jasnym kolorem skóry, topytanie jest, czy u osób zciemną karnacją on będzie taksamo dobry.Jeżeli był trenowany tylko iwyłącznie na danych z dorosłych udorosłych, to czy on będziesię sprawdzał u dzieci?Więc to są wyzwania związanez zastosowaniem AI.

Black box.No to jest słynna dyskusja.Wiemy, co jest na wejściu,wiemy co jest na wyjściu, alenie wiemy, w jaki sposóbmodel doszedł do tego wniosku.Proszę państwa, my w medycyniez większością rzeczy nie wiemy, jakto się dzieje.Żeby tu przybliżyć coś, cojest dla mnie bardzo bliskie, czylina przykład przeszczepy mikrobioty kałowej.Fantastycznie działają na wracających zakażeniachClostridioides difficile.Pani profesor Hryniewicz siedzi tutajobok, pewno to potwierdzi.Problem jest taki, że mynie wiemy w żaden sposób, wjaki sposób to działa, ajednak jest stosowane, w wytycznych jestto w tej chwili uznanainterwencja.Walidacja.

To, co działa w Bostonie,niekoniecznie działa w Białymstoku.Czyli ten model, który zostałwypracowany dla celów badań w jakimśbadaniu naukowym, musi być-Musi byćzweryfikowany również, czy on działa wrealnym, w realnym życiu.

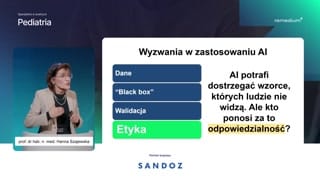

No i wreszcie temat naoddzielną dyskusję, czyli zagadnienia etyczne.AI potrafi dostrzegać wzorce, którychludzie nie widzą, ale kto zato ponosi odpowiedzialność?Temat, tak jak powiedziałam naoddzielną dyskusję, ja tylko państwu pokażęsześć zasad WHO, z którychjedna podstawowa jest niezwykle ważna imam nadzieję, że to jużtrochę przebrzmiało w tym, co mówiłamwcześniej, że za każdym razemstosując narzędzia AI, to człowiek, toczłowiek zawsze podejmuje ostateczną decyzję.Po angielsku to się mówihuman oversight.To człowiek patrzy na to—można powiedzieć tak, jak powiedziałam, człowiekzawsze decyduje.

Proszę państwa, powiedziałam króciutko opodstawowych terminach związanych z AI.Powiedziałam przykłady AI w medycyniei pokazałam Państwu, jakie są wyzwaniaw zastosowaniu AI.A teraz kluczowe pytanie, czyAI poprawia wyniki kliniczne?I wracam z powrotem doraportu, który został dopiero co opublikowanyw JAMIE i wniosek, któryjest niestety dla nas nie bardzodobry.Brak jest dowodów na to,że AI poprawia wyniki leczenia.Dokładność algorytmu, czyli to, naco w badaniach naukowych tak bardzosię, na czym się skupiamy,nie oznacza automatycznie korzyści dla pacjenta.Efekt jest zależny od bardzowielu czynników od wdrożenia, od szkolenia,od organizacji pracy i dopuszczeniejakiegoś narzędzia, tak jak na przykładmówimy zielone światło od FDA,FDA.Bardzo dobrze.Nie ma tak bardzo wcalewielu narzędzi, które ją mają, aleto dopuszczenie nie oznacza udowodnionejskuteczności klinicznej.I te dwa terminy, tedwie sytuacje należy odróżniać.

Dlaczego tak się dzieje ico należy zrobić?No niewątpliwie testować AI wrealnej praktyce klinicznej.To, że coś działa naUniwersytecie w Bostonie, nie oznacza, żebędzie działał, działało w szpitaluw Białymstoku.Sprawdzać wpływ na pacjentów, nietylko dokładność algorytmu.Czyli musimy znowu wracamy dotego, że musimy zobaczyć, jak todziała w realnej sytuacji.Należy to wdrażać z zespołem.Czyli niezwykle ważne jest to,że nie przynosi, ktoś wprowadza narzędzieAI, o którym nikt nicnie wie.Nie!To jest szkolenie, to jestsensowne wpasowanie w organizację pracy.Musimy wiedzieć dokładnie, w którymmomencie i co to AI będzie,to narzędzie będzie robiło isamo wdrożenie to jest dopiero początek.

Należy monitorować efekty po wdrożeniu,poprawiać lub wycofywać narzędzie.Czyli sam AI, samo narzędzie,które gdzieś jest, gdzieś funkcjonuje, nieoznacza, że to jest koniecnaszej działalności.

No i niestety znowu zławiadomość.To jest z tego raportuz JAMY i słowa Roberta Kalifa,byłego szefa FDA.Nie ma dziś w USAsystemu ochrony zdrowia zdolnego do rzetelnejwalidacji klinicznych algorytmów AI.

Jeszcze raz chciałabym zwrócić państwauwagę to, że gdzieś coś zostałoopracowane jako model naukowy, nieoznacza, że to będzie działał, działaw realnych, w realnych warunkach.

Czyli wracając do sytuacji, odktórej zaczęłam to dzisiejsze spotkanie zPaństwem.Jutro w przychodni w szpitaluszef, kolega, przedstawiciel firmy przychodzi znowym urządzeniem AI i zadajemysobie wszyscy pytanie słuszne stosować czynie?I to są pytania, którewarto sobie zadać.Czy to realnie pomaga?Czy to, że narzędzie, któremam wprowadzić, czy ono poprawia opiekęnad pacjentem?Czy ono poprawi decyzje kliniczne?Czy ono poprawi organizację pracy?Czy może tylko wygląda supernowocześnie?

Czy mogę temu ufać?Skąd pochodzą dane?Czy są aktualne i czypasują do moich pacjentów?Czy to był model wytrenowanytylko i wyłącznie na dorosłych?A ja jestem pediatrą.W związku z tym niejestem pewna, czy on się napewno sprawdzi u pacjenta pediatrycznego.

Czy to jest bezpieczne?Kiedy może się mylić?Jaką informację muszę wiedzieć, czywiem, kiedy nie należy używać tegonarzędzia?I wreszcie niezwykle ważne pytanie,kto prawnie odpowiada, gdy coś pójdzieźle?

Czy ja odpowiadam jako lekarz,czy odpowiada szpital, czy producent?Proszę zauważyć, że bardzo wielemodeli, mimo że są dostępne, mimoże zostały zaakceptowane przez FDAi tak się głównie odnoszę doStanów, bo najwięcej danych stamtądpochodzi.To nie zostaną, nie są,nie są ubezpieczalnie tego nie chcą,nie chcą, nie akceptują, dlatego,że ciągle jest mnóstwo kwestii regulacyjnych,prawnych, które nie zostały rozwiązane.

Czyli wracając do pytania, którezadali mi organizatorzy tego dzisiejszego spotkania.Realna pomoc czy zagrożenie?Znowu wrócę do raportu zJAMY.AI zmienia ochronę zdrowia nabezprecedensową, bezprecedensową skalę.Potencjalne korzyści są ogromne, aleryzyka również są duże.

Odpowiedzialne wdrożenie wymaga oceny skuteczności,bezpieczeństwa i aspektów etycznych, ale taocena skuteczności nie tylko, żejest nowe, jest niezwykle ważne.I jeszcze bardzo ważna uwaga,że AI nie zastąpi lekarzy.Co do tego nie mawątpliwości, ale zmieni sposób naszej pracy.

I na koniec, I nakoniec Stanisław Lem.Z postępem technicznym jest takjak z brzytwą można się niąogolić, a można i gardłopodciąć.Mam nadzieję, że nie podetniemysobie gardeł.Dziękuję państwu bardzo za uwagę.Dziękuję.

Rozdziały wideo

Wprowadzenie i postawienie pytania o AI w medycynie

Podstawowe terminy: sztuczna inteligencja i uczenie maszynowe

Trening modeli na przykładzie rozpoznawania zapalenia płuc

Dlaczego teraz: dane, moc obliczeniowa i nowe algorytmy; obrazowanie medyczne

Narzędzia kliniczne w pediatrii i rynek aplikacji zdrowotnych

Organizacja pracy, AI scribe i modele językowe — korzyści i ograniczenia

Wskazówki praktyczne i wyzwania związane z jakością, ilością i reprezentatywnością danych

Zjawisko black box, walidacja i etyka; nadzór człowieka